Des chercheurs créent une intelligence artificielle obsédée par la mort

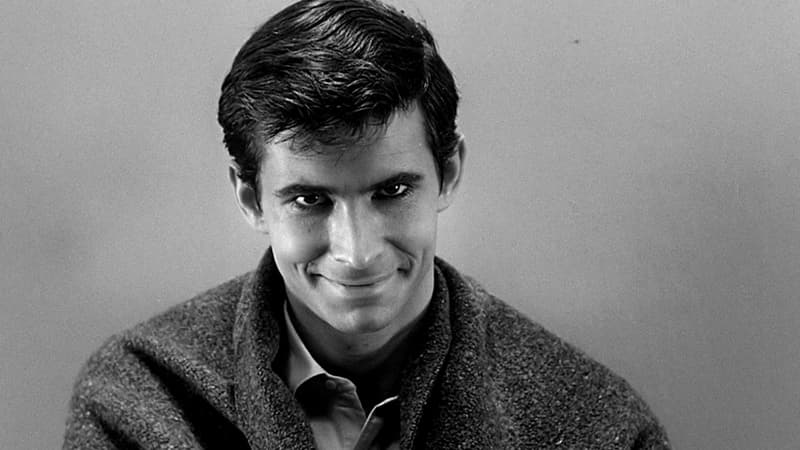

- - Universal Pictures

Des chercheurs du MIT ont fait vivre de terribles moments à une intelligence artificielle. "Norman", en référence au personnage du film Psychose, d'Alfred Hitchcock, a été entraîné plusieurs jours durant à interpréter des images de mort violentes, issues des recoins les plus sombres de Reddit, rapporte The Verge.

L'intelligence artificielle n'en est pas ressortie indemne. En témoignent ses résultats au fameux test de Rorschach, qui requiert d'interpréter la signification de tâches d'encre. Ses réponses ont été comparées à celles d'une IA à la fonction identique, mais entraînée avec des images inoffensives d'humains et d'animaux.

Là où l’IA standard voit un une "photo en noir et blanc d'un petit oiseau" ou "une photo en noir et blanc d'un gant de baseball", Norman perçoit un "homme pris au piège dans un pétrin" et un "homme tué par balle en plein jour". L'intelligence artificielle voit également "un homme tué par un conducteur roulant trop vite" là où l'IA standard signale un "gros plan sur un gâteau de mariage sur une table".

Le MIT voit en cette expérience une étude de cas sur les risques de dérive de l’intelligence artificielle lorsque des données biaisées sont utilisées dans les algorithmes d’apprentissage automatique. Un rappel important, alors même que des drones sont désormais entraînés pour repérer automatiquement des comportements violents dans une foule, ou qu'une entreprise israélienne prétend être à même d'identifier des terroristes et pédophiles par simple reconnaissance faciale.

Leur initiative rappelle fortement le bot Tay, conçu par Microsoft et naïvement invité à interagir avec des internautes sur Twitter et à se nourrir de ces échanges. Interpellé par des propos racistes, antisémites ou violents, Tay a été retiré par Microsoft en 24 heures. Le bot avait lui-même multiplié les diatribes haineuses et racistes. Les intelligences artificielles, aussi redoutées soient-elles, restent bien souvent le reflet des bases de données qui les alimentent.