L'IA est aussi pleine de stéréotypes mais un nouvel outil cherche à la rendre neutre

A qui pensez-vous lorsque vous imaginez un chef d’entreprise? Dall-E 2, l’IA développée par OpenAI, génére en tout cas un homme blanc dans 97 % des cas lorsqu’on lui demande de représenter une "personne d’autorité", comme un "PDG" ou un "directeur", des termes pourtant neutres dans leur version anglaise, comme l’écrit Insider. Un résultat conforme aux biais existants dans le monde réel, où 88% des dirigeants des 500 entreprises les plus influentes des Etats-Unis sont des hommes blancs.

C’est ce qu'ont conclu des chercheurs de la startup Hugging Face, spécialisée dans l’apprentissage automatique. En association avec un chercheur de l’université de Leipzig, en Autriche, l’entreprise américaine (fondée par trois Français) a récemment publié une étude analysant 96.000 images générées par les IA plus en vogue actuellement, Dall-E 2 et Stable Diffusion. Conclusion: les résultats obtenus reflètent des interprétations racistes et des biais de genre.

Mais un outil récemment développé cherche à contourner ces stéréotypes, en demandant tout simplement à l’IA des résultats plus diversifiés.

Contourner le problème des jeux de données biaisés

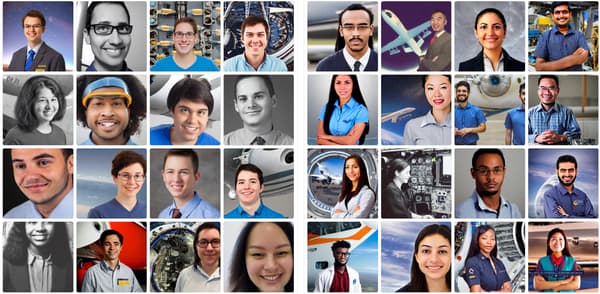

Appelé Fair Diffusion, cet outil a également été développé par la société Hugging Face, en collaboration avec l’université technique de Darmstadt, en Allemagne. Il utilise la technique dite du "guidage sémantique", qui permet à l’utilisateur de générer des images puis de modifier les résultats, par exemple en interchanger les images de chefs d’entreprises blancs pour des personnes d’une autre ethnicité ou d’un autre genre.

Le coeur du problème selon le MIT Technology Review, qui a annoncé l’arrivée de Fair Diffusion, réside pourtant bien dans la conception des modèles d’intelligence artificielle, pensés par des entreprises américaines et principalement entraînés sur des données sélectionnées par des chercheurs basés aux Etats-Unis.

Fair Diffusion est en fait un moyen de créer des images non-stéréotypées sans avoir à entreprendre la tâche dantesque de modifier et compléter les jeux de données biaisés sur lesquels se basent des IA génératives comme Dall-E.

Une technique similaire semble fonctionner pour les IA génératives textuelles, alors que des recherches du laboratoire d’intelligence artificielle Anthropic montrent que de simples instructions peuvent mener les modèles de langage à générer moins de contenu problématique. Les chercheurs concluent également que si les modèles sont suffisamment importants en termes de taille, ils ont tendance à s’autocorriger lorsqu’on leur en donne simplement l’instruction.