Comment Google veut supprimer les biais raciaux des photos de ses smartphones

Google veut supprimer les biais raciaux des photos de ses smartphones - YouTube (Google)

Une peau trop grise, trop sombre ou artificiellement trop éclairée. Ces difficultés, fréquemment rencontrées par les personnes à la peau noire, constituent un nouveau cheval de bataille pour Google. Lors de sa conférence de presse Google I/O organisée ce 18 mai, l’entreprise américaine a annoncé des changements à venir dans les algorithmes des appareils photo de ses smartphones (baptisés Pixel). Une mise à jour qui pourrait être rétroactive et concerner les modèles déjà commercialisés.

Sur un smartphone plus encore que sur un appareil photo “traditionnel”, les algorithmes jouent un rôle prépondérant dans le rendu final. Ainsi, deux smartphones équipés d’un capteur photo identique peuvent proposer pour l’un de mauvais résultats et pour l’autre de superbes clichés, selon la qualité du logiciel chargé d’interpréter les données fournies par ce capteur.

Diversifier la base de données

“Pour les personnes de couleur, la photographie ne les a pas toujours vues telles qu’elles voulaient l’être, y compris en utilisant les produits Google” a admis Sameer Samat, responsable d’Android, lors de la Google I/O.

“Pour proposer des photos de smartphone authentiques pour tout le monde, nous avons travaillé avec un panel d’experts afin de concevoir un appareil photo plus précis et plus inclusif” précise l’entreprise.

Les algorithmes de photographie de Google, qui figurent parmi les meilleurs du marché, s’appuient sur d’immenses bases de données d’images. Ces dernières entraînent la machine à reprendre les caractéristiques des clichés les plus réussis.

Pour aider ses algorithmes à mieux restituer les peaux noires, Google a ajouté “des milliers” d’images supplémentaires chargées de diversifier les bases de données.

Le but est de faire évoluer l’interprétation de la machine à chaque photo prise par l’utilisateur, notamment en ce qui concerne la balance des blancs (couleur dominante sur l'image) et le niveau d’exposition (niveau de luminosité de l’image).

L’apport du HDR

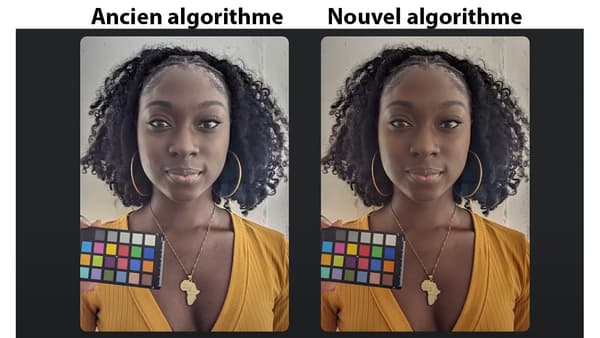

Google, qui a par ailleurs diffusé des exemples de photos de personnes noires avant et après la modification de son algorithme, estime que ses efforts sur la balance des blancs permettent de mieux restituer les teintes naturelles de toutes les couleurs de peau, empêchant une désaturation artificielle de ces dernières.

L’entreprise a par ailleurs travaillé son algorithme de détection d’arrière-plan, utilisé sur le mode portrait de ses smartphones pour y appliquer un flou artistique. L’entreprise assure que ses logiciels sont désormais capables de mieux détecter les cheveux frisés ou crépus pour les isoler en premier plan.

Google ne précise pas si ses nouveautés auront un impact sur des clichés mettant en scène des personnes noires aux côtés de personnes blanches, avec des difficultés d’exposition bien connues des couples mixtes.

Depuis plusieurs années, les fabricants de smartphones ont toutefois amélioré la photo de scènes avec une large plage dynamique (tons très clairs et très foncés) grâce à la popularisation des fonctions HDR.

Ainsi, chaque photo prise par un smartphone Apple, Samsung ou Google est en réalité une combinaison d’une multitude de clichés pris instantanément (et sans que l’utilisateur ne s’en rende compte) avec à chaque fois un niveau d’exposition différent, pour restituer les éléments de détails qui apparaissent dans chacune des combinaisons.